Érase una vez…

María llevaba días trabajando en un proyecto importante. En una videollamada decisiva, su rostro se tensó, la mandíbula se le apretó. La herramienta de análisis automático, diseñada para “interpretar emociones”, marcó “neutral”. Su jefe abrazó la interpretación y dijo: “Todo bien, no parece que estés molesta”. María sintió que su voz interior se perdía.

Ese mismo algoritmo interpretó que su compañero —con expresión similar, cejas tensas— estaba “serio pero concentrado”. En su código, el modelo había “aprendido” que las mujeres sonríen, que las cejas arquedas indican sorpresa masculina, y que la ira femenina es “lechosa”, algo intermedio entre tristeza y enfado. Así, la máquina juzgaba sin escuchar, sin contexto. Y el sesgo, invisible, dejaba fuera lo que María reclamaba: ser reconocida en su humanidad completa.

Este es un breve relato creado por la propia Inteligencia Artificial, que nos cuenta una historia cualquiera, pero importante, titulada “Cuando la máquina no entiende su ira”, sobre cómo un pequeño error programado es un reflejo ampliado de lo que sucede cuando la afectividad digital no se diseña para todas las personas.

Y… ¿QUÉ ES LA TECNOLOGÍA AFECTIVA?

La tecnología afectiva (o affective computing) se refiere a sistemas capaces de detectar, interpretar y, en ocasiones, responder a las emociones humanas. Estas tecnologías se usan en asistentes virtuales, diagnósticos de salud mental, publicidad emocional, interfaces adaptativas y más.

Se apoya en sensores (faciales, de voz, fisiológicos) y modelos de inteligencia artificial que clasifican estados emocionales como alegría, tristeza, ira o miedo. La emoción, sin embargo, no es un dato objetivo: depende del contexto cultural, individual y social. Un mismo gesto en Asia, África o Europa puede tener connotaciones distintas.

Este análisis se realiza en:

- “A Systematic Literature Review of Modalities, Trends and Limitations in Emotion Recognition, Affective Computing and Sentiment Analysis” documenta los sesgos y limitaciones metodológicas que existen en datasets, modelos y aplicaciones.

- El estudio Responsible AI: Gender bias assessment in emotion recognition, se analizan redes neuronales que muestran brechas de precisión entre rostros masculinos y femeninos, identificando que los modelos más sesgados cometen más errores al clasificar emociones en mujeres.

- Towards affective computing that works for everyone, donde se advierte que muchos sistemas tienen desempeño desigual entre distintos géneros, etnias y edades, debido a la falta de diversidad en sus datos y diseños.

Entonces, ¿cuáles son los retos inherentes a la Tecnología afectiva?

- Las bases de datos usadas en entrenamiento suelen estar dominadas por rostros masculinos, blancos, de expresión pronunciada y en condiciones controladas.

- Las etiquetas emocionales (lo que se considera “ira”, “alegría”, “neutral”) se definen desde normas culturales occidentales.

- Las emociones no son universales ni visibles: una mujer puede ocultar ira o modular su expresión según normas sociales, y la máquina “no la ve”.

- Los algoritmos pueden reforzar sesgos de género, raza, edad si no se diseñan explícitamente con equidad.

TECNOLOGÍA AFECTIVA CON ENFOQUE DE GÉNERO: ¿CÓMO APRENDER A “SENTIR” CON EQUIDAD?

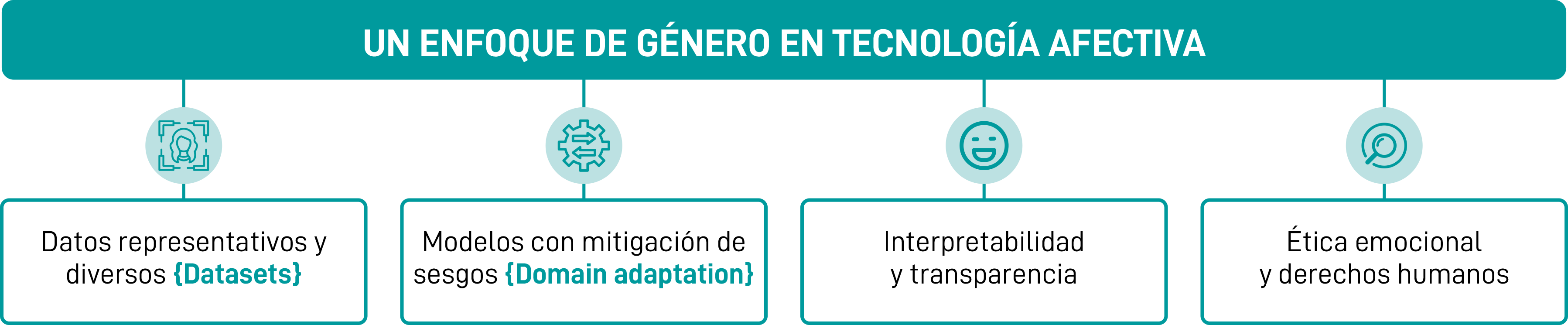

Un enfoque de género en tecnología afectiva implica:

Datos representativos y diversos

Es fundamental construir datasets que incluyan mujeres (de todas las edades, expresiones, tonos de piel, contextos culturales), para que el algoritmo “vea” toda la magnitud de la expresión humana.

Por ejemplo, en el estudio Gender biases in the training methods of affective computing de la Universidad Carlos III de Madrid, se demostró que la herramienta SAM de etiquetado emocional no era neutral con las mujeres, y que realizar ajustes gráficos y metodológicos mejoraba la precisión para ellas.

Modelos con mitigación de sesgos

Técnicas modernas como domain adaptation pueden reducir el sesgo demográfico entrenando modelos con datos neutrales y ajustando distribuciones emocionales. El reciente trabajo Domain adaptation for bias mitigation in affective computing: use cases for facial emotion recognition and sentiment analysis, lo demuestra en tareas de reconocimiento facial y de texto.

Otro ejemplo emergente es EMO‑Debias, evaluación de técnicas para reducir sesgo en reconocimiento emocional de voz (Speech Emotion Recognition), comparando 13 métodos distintos para asegurar equidad sin sacrificar precisión.

Interpretabilidad y transparencia

Los sistemas de inteligencia artificial que reconocen emociones no pueden ser cajas negras. Es decir, deben ser capaces de explicar cómo y por qué han llegado a una conclusión emocional: ¿Qué gesto facial ha sido determinante para interpretar “tristeza”? ¿Qué patrón de voz ha activado la etiqueta “alegría”? ¿Qué variables han pesado más en la clasificación final?

Esta capacidad de interpretación no solo ayuda a ganar confianza en los sistemas, sino que permite a quienes los desarrollan identificar y corregir sesgos, depurar errores y mejorar los modelos sin reforzar estereotipos. Además, garantiza derechos fundamentales en contextos donde estas decisiones pueden tener impacto real (por ejemplo, entrevistas de trabajo automatizadas, diagnósticos de salud mental o decisiones judiciales apoyadas en IA).

La transparencia debe estar presente desde el diseño hasta el uso final, incorporando:

- Explicaciones accesibles para personas usuarias (especialmente cuando sus datos están siendo analizados emocionalmente).

- Sistemas auditables por terceros que puedan revisar cómo funciona el algoritmo en distintas poblaciones.

- Métricas de equidad que midan si el modelo funciona de forma justa entre géneros, razas o edades.

En definitiva, hablar de transparencia en IA emocional es hablar de justicia algorítmica. Porque si la tecnología influye en cómo se nos percibe, necesitamos saber cómo y por qué nos interpreta así.

Ética emocional y derechos humanos

Interpretar emociones de forma automática puede infringir privacidad, aumentar vigilancia o imponer juicios morales. Por eso, los desarrollos deben estar acompañados por marcos éticos, revisión de impacto social y participación de expertas en género, derechos digitales, psicología y sociología.

En el artículo Affective Computing and Emotional Data: Challenges and Implications se advierten las demandas de justicia y equidad en el uso de inteligencia emocional, señalando que muchos sistemas actuales presentan grandes disparidades si se aplican a personas diversas.

El papel de las mujeres en la tecnología afectiva

Las mujeres tienen un papel fundamental en la construcción de una tecnología emocional más justa, porque:

- Aportan una mirada histórica y crítica sobre cómo se ha invisibilizado su expresión emocional y se ha interpretado desde estereotipos.

- Tienen experiencia directa en ser malinterpretadas por sistemas automatizados que replican sesgos culturales (como sonreír más por presión social o modular su voz para ser “aceptadas”).

- Están liderando líneas de investigación disruptivas en universidades, startups y centros de innovación para diseñar IA con empatía, diversidad y justicia.

Por eso, es urgente que las mujeres no solo usen tecnología afectiva, sino que la diseñen, la regulen, la evalúen y la transformen desde dentro, en todos los ámbitos: investigación, empresas, instituciones públicas y sociedad civil.

CAMINOS HACIA UNA AFECTIVIDAD ALGORÍTMICA INCLUSIVA

La construcción de una tecnología afectiva inclusiva no es solo una cuestión técnica, sino una decisión social, ética y política. Para que las máquinas aprendan a “sentir” sin discriminar, necesitamos actuar en distintos niveles: público y privado, individual y colectivo. Estas son algunas de las medidas clave que pueden marcar la diferencia:

Administraciones públicas y gobiernos

- Legislar con perspectiva de derechos digitales y género: garantizar que los algoritmos de reconocimiento emocional respeten la privacidad, no perpetúen sesgos y sean auditables.

- Incluir cláusulas éticas y de género en la contratación pública tecnológica, para que cualquier solución tecnológica financiada con fondos públicos incorpore medidas de equidad y transparencia.

- Impulsar estándares nacionales e internacionales sobre uso de inteligencia artificial emocional en sectores sensibles como la salud, la educación o los recursos humanos.

- Financiar investigación interdisciplinar (tecnología + psicología + sociología + feminismo) que analice los efectos sociales de la IA afectiva y promueva nuevos modelos.

Empresas y sector tecnológico

- Auditorías de sesgos emocionales: evaluar de forma periódica cómo sus sistemas afectan de forma desigual según el género, la edad, la cultura o la raza.

- Diseño ético desde el inicio (ethics by design): incorporar principios éticos y diversidad en los equipos desde las primeras fases del desarrollo tecnológico.

- Formación continua en diversidad emocional y sesgos algorítmicos para equipos de desarrollo, diseño y producto.

- Incluir perfiles no técnicos en los procesos de diseño de IA: psicólogas, antropólogas, expertas en género, neurocientíficas y otras disciplinas sociales.

Entidades sociales, educativas y culturales

- Generar conciencia crítica: campañas de sensibilización sobre cómo operan estos sistemas y sus riesgos en términos de derechos, estereotipos o discriminación.

- Crear espacios de co‑diseño con ciudadanía: foros, laboratorios, talleres donde las personas participen en la definición de los algoritmos que les afectan.

- Fomentar referentes femeninos y diversos en el ámbito de la tecnología emocional, para visibilizar que la inteligencia emocional también tiene rostro femenino, racializado y plural.

HACIA MÁQUINAS QUE “SIENTAN” CON NOSOTRAS

La afectividad algorítmica no es (solo) distinguir una sonrisa o una ceja arqueada: es construir sistemas que entiendan el matiz, el contexto, la identidad y la emocionalidad de todas las personas. Que no interpreten desde un estándar masculino, sino que aprendan a “sentir” con nuestras experiencias.

Que las máquinas lean nuestras emociones no debe significar que nos reduzcan a estereotipos. Debe abrir la puerta a un diálogo más humano entre la tecnología y las personas: uno en el que nuestras voces, expresiones y sentimientos sean reconocidos con justicia.

Y ese camino se construye desde la diversidad: más mujeres en IA emocional, más disciplinas juntas (ética, humanidades, ciencia) y más ciudadanía participando. Porque si las emociones son políticas… los algoritmos también pueden serlo.

Necesitamos una inteligencia artificial que no solo detecte emociones, sino que entienda su diversidad, que respete las distintas formas de sentir y que nunca confunda lo diferente con lo incorrecto. Y eso solo será posible si apostamos por una tecnología emocional verdaderamente humana: plural, empática y construida colectivamente.

Porque la emoción no tiene un solo rostro… y la tecnología tampoco debería tenerlo.